Seit dem letzten Artikel hier ist ja ein wenig Zeit vergangen, was ich mit einer Menge zu erledigender Aufgaben entschuldigen möchte. Jetzt ist aber wieder Zeit, und die möchte ich gleich für einen neuen Artikel benutzen. Heute soll es um künstliche Intelligenz gehen, beziehungsweise um eine spezielle Form davon: die künstlichen neuronalen Netze.

Künstliche Intelligenzen (abgekürzt KI) sind ja ein beliebtes Thema in Science-Fiction-Literatur und -Filmen, wobei es meist (aus mir unerfindlichen Gründen) früher oder später dazu kommt, dass die KI Allmachtsphantasien entwickelt oder auf andere Art und Weise “den Verstand verliert”. Die KI in derartigen Werken wird meist als sehr weit fortgeschritten und dem Menschen mindestens ebenbürtig, wenn nicht sogar überlegen, dargestellt; was dabei aber meist zu kurz kommt, ist eine Beschreibung der technologischen Grundlage dieser künstlichen Intelligenz. Ein geeigneter Kandidat für derartig unberechenbare Intelligenzen sind nun eben die künstlichen neuronalen Netze, da sie dem menschlichen Gehirn nachempfunden sind und ähnlich funktionieren. Aber von vorn.

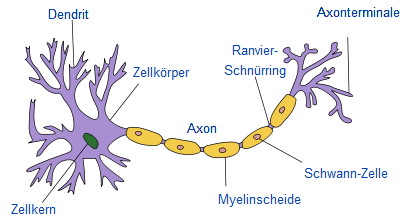

Unser Gehirn besteht zum überwiegenden zu einem großen Teil aus Nervenzellen oder Neuronen, schätzungsweise einige 100 Milliarden an der Zahl. Eine Nervenzelle besteht hauptsächlich aus drei wichtigen Bestandteilen: dem Zellkörper, den Dendriten und dem Axon (siehe Bild). Der Zellkörper ist der zentrale Bestandteil der Zelle und enthält alle wichtigen Bestandteile, die zum Überleben und Funktionieren der Zelle wichtig sind. Die Dendriten sind gewissermaßen die “Eingänge” der Zelle – über sie werden Reize von anderen Nervenzellen an den Zellkern Zellkörper übertragen. Das Axon ist schließlich der “Ausgang” der Zelle, da die Zelle hierüber Reize an andere Neuronen übertragen kann (die Axonterminale in der Abbildung sind über Synapsen mit Dendriten weiterer Zellen verbunden).

Aufbau eines Neurons (Quelle: Wikipedia)

Ein Neuron funktioniert nun folgendermaßen: über die Dendriten werden von anderen Nervenzellen oder auch Sinneszellen eingehende Reize beziehungsweise Signale an den Zellkörper, konkret: an den Axonhügel (den Ansatz des Axons) weitergeleitet. Dadurch baut sich am Axonhügel ein sogenanntes Erregungspotential auf, also eine elektrische Spannung; (fast) gleichzeitig eingehenden Reize summieren sich hierbei auf. Übersteigt das aufsummierte Erregungspotential am Axonhügel eine bestimmte Schwelle (die folgerichtig als Schwellenpotential bezeichnet wird), wird ein Aktionspotential ausgelöst – man sagt, die Zelle feuert – und über das Axon an die verbundenen Dendriten und damit Nervenzellen verteilt (für die biologisch interessierten: die Reizübermittlung über das Axon und die Dendriten erfolgt elektrisch; zwischen diesen beiden Elementen werden die Reize über die Synapsen meist auf chemischem Weg übermittelt). Je kürzer ein Dendrit ist (also je näher sich seine Synapse am Zellkörper befindet), desto stärker ist auch das Signal, welches das Erregungspotential aufbaut. Noch einmal zusammengefasst: Reize werden über die Dendriten an den Zellkörper geleitet, wo sie sich aufsummieren; die Stärke der einzelnen Reize hängt von der Entfernung ihrer Ursprungssynapsen zum Zellkörper ab. Übersteigt die Summe der Reize einen gewissen Schwellwert, so wird über das Axon ein Signal (fester Stärke, das Aktionspotential) an die umliegenden Zellen weitergeleitet – die Zelle feuert. Das Zusammenspiel aller Neuronen im Körper, allen voran derer im Gehirn, stellt die Reiz- und Informationsverarbeitung dar, die allen Tieren zu eigen ist und von uns allgemein als “Denken” bezeichnet wird (wobei natürlich auch das gesamte vegetative

Nervensystem, also die automatisch ablaufenden Vorgänge wie Steuerung des Blutkreislaufes, Verdauung usw. über diese Reizübertratung gesteuert werden).

In den 40er und 50er Jahren des letzten Jahrhunderts (direkt in den Anfängen der Informatik selber!) kamen nun einige clevere Leute auf die Idee, diesen ausgeklügelten Mechanismus der Reizverarbeitung mit Hilfe der gerade aufkommenden Computertechnologie nachzubilden – das war die Geburtsstunde der künstlichen neuronalen Netze (kurz KNN). Im Prinzip ist ein KNN die Nachbildung eines Gehirns mit dem Ziel, die enormen Verarbeitungsfähigkeiten von Gehirnen im Computer nachzubilden. Mittlerweile gibt es die unterschiedlichsten Varianten derartiger künstlicher Netze; im Folgenden und den weiteren Artikeln werde ich das Prinzip im Allgemeinen sowie einige typische Vertreter näher beschreiben.

Kommentare (14)